参加业界技术大会的资料分享。持续多天线下举办,多个并行主题,QCon等

Jakarta EE 11 平台规范就绪,以及 Spring 7 对 JEE 11的支持

随着 Jakarta EE Platform 11 主页 上的“正在开发”字样被移除,平台规范 pdf 文档也发布了正式版本。

Jakarta EE 11规范将会很快发布!

做国内优秀的中间件产品和提供一流的开源技术服务

2018年永源中间件

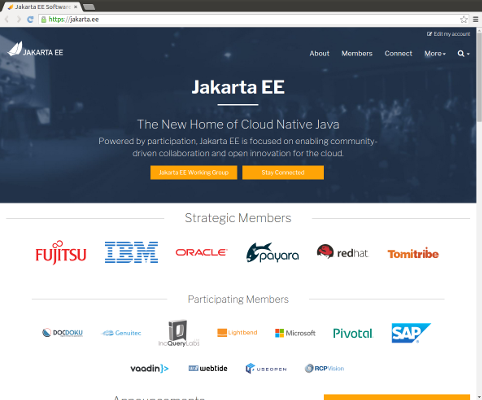

成为Eclipse Jakarta EE专家组成员公司

参加业界技术大会的资料分享。持续多天线下举办,多个并行主题,QCon等

参加开源社区技术活动的资料分享,如GreenTea JUG, Jakarta EE社区等

完整、系统的阐述分布式中间件架构的技术,帮助技术型企业选择合适的中间件技术栈

Apache Tomcat 11.0 实现了 Jakarta EE 11 和 Servlet 6.1 规范

开源软件和中间件领域的技术博文和行业动向

在 June 18, 2025

随着 Jakarta EE Platform 11 主页 上的“正在开发”字样被移除,平台规范 pdf 文档也发布了正式版本。

Jakarta EE 11规范将会很快发布!

在 April 30, 2025

重要大版本:

在 March 1, 2025

在过去的30年,各种技术层出不穷,热点快速切换。 异构环境、分布式、大数据、微服务、容器云原生,每个时代都催生一批新的明星技术和产品。 如今在人工智能时代,大语言模型、GPU、Agent等成为热点词。

那么在AI时代,究竟什么才是技术时期发展的驱动力呢?

Copyright (c) 2021 - 2025, Useopen middleware; All rights reserved.